Продолжаем отвечать на главные вопросы про индексацию сайтов. В первой части статьи мы уже дали ответы на 4 вопроса. Сегодня вновь начнем с самого простого.

5) Сколько страниц уже в индексе поисковой системы?

6) Как ускорить процесс индексации?

7) Какими должны быть ссылки и размер страниц?

8) Краулинговый спрос и бюджет: что об этом нужно знать?

Начнем с простого.

Продолжаем отвечать на главные вопросы про индексацию сайтов. В первой части статьи мы уже дали ответы на 4 вопроса. Сегодня вновь начнем с самого простого.

5) Сколько страниц уже в индексе поисковой системы?

6) Как ускорить процесс индексации?

7) Какими должны быть ссылки и размер страниц?

8) Краулинговый спрос и бюджет: что об этом нужно знать?

Начнем с простого.

Вопрос 5. Сколько страниц уже в индексе поисковой системы?

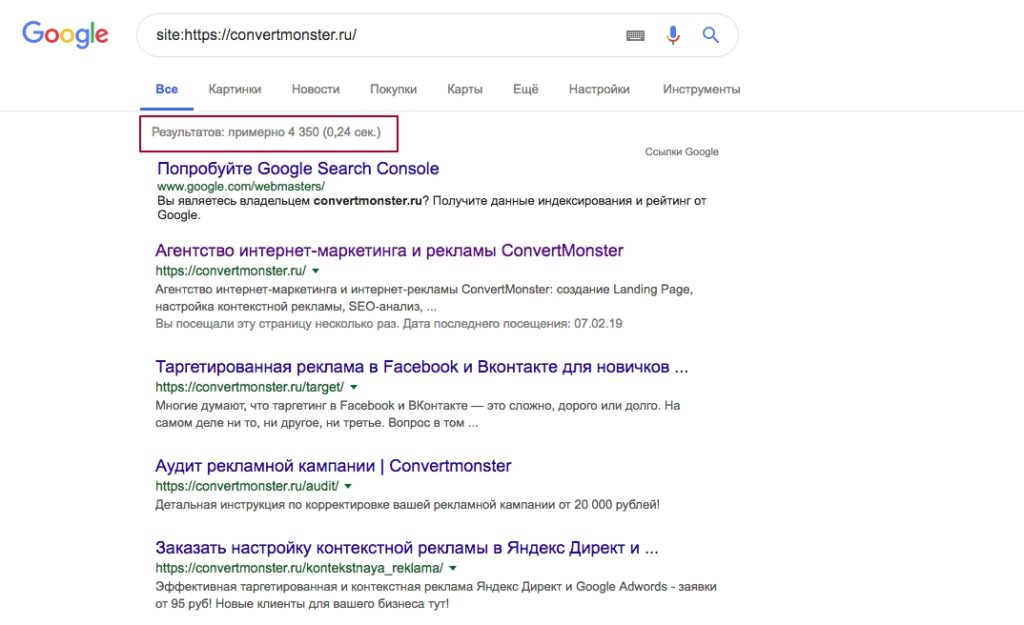

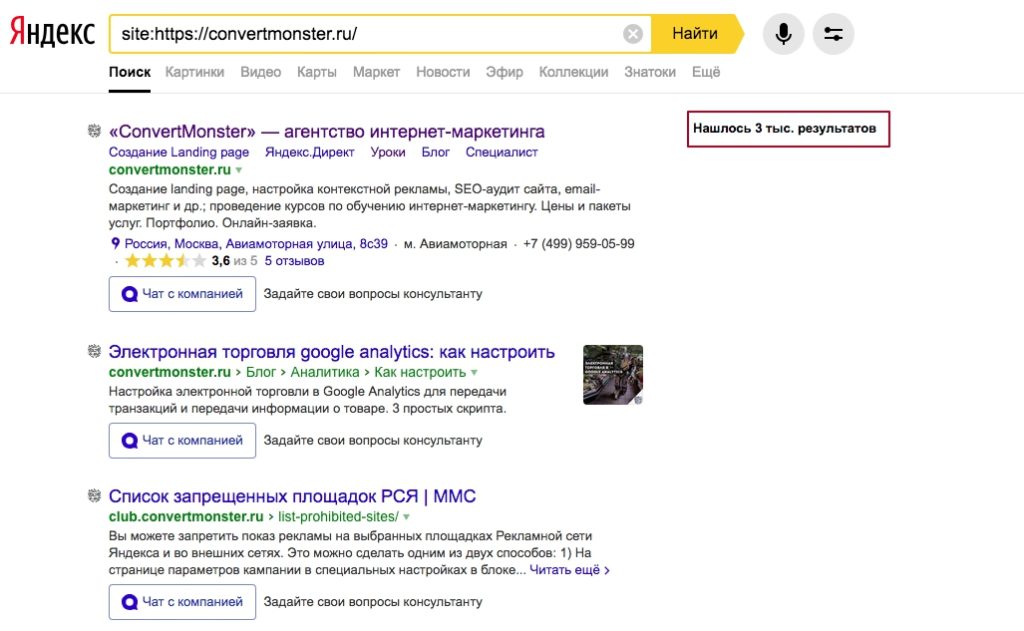

Есть сразу несколько простых способов, которые вы наверняка уже знаете. Во-первых, это можно проверить с помощью специальный поисковых операторов. Просто введите в поисковой строке оператор site: и домен сайта: Внизу под строкой поиска (в Яндексе - в самой строке правее) отображается примерное количество страниц вашего сайта, проиндексированных поисковой системой.

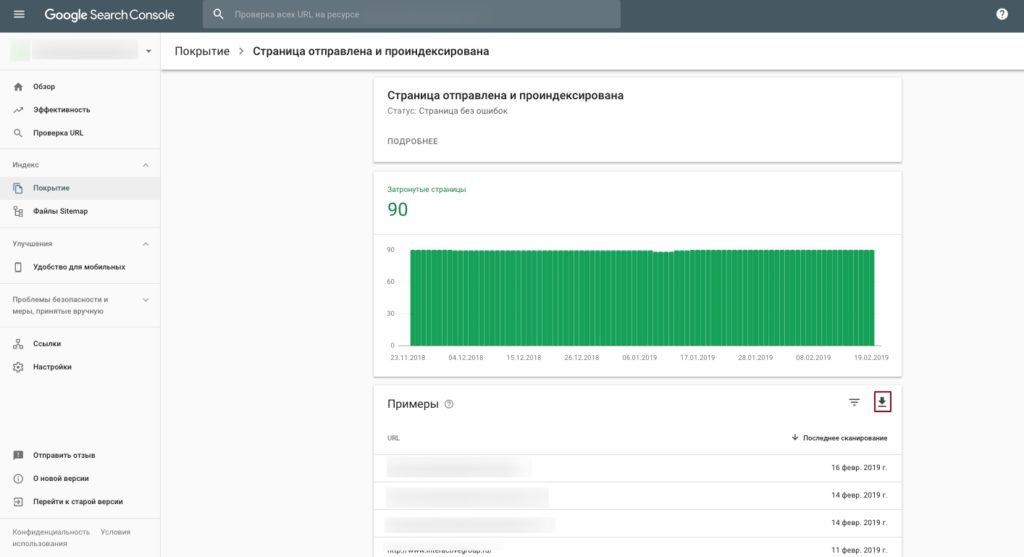

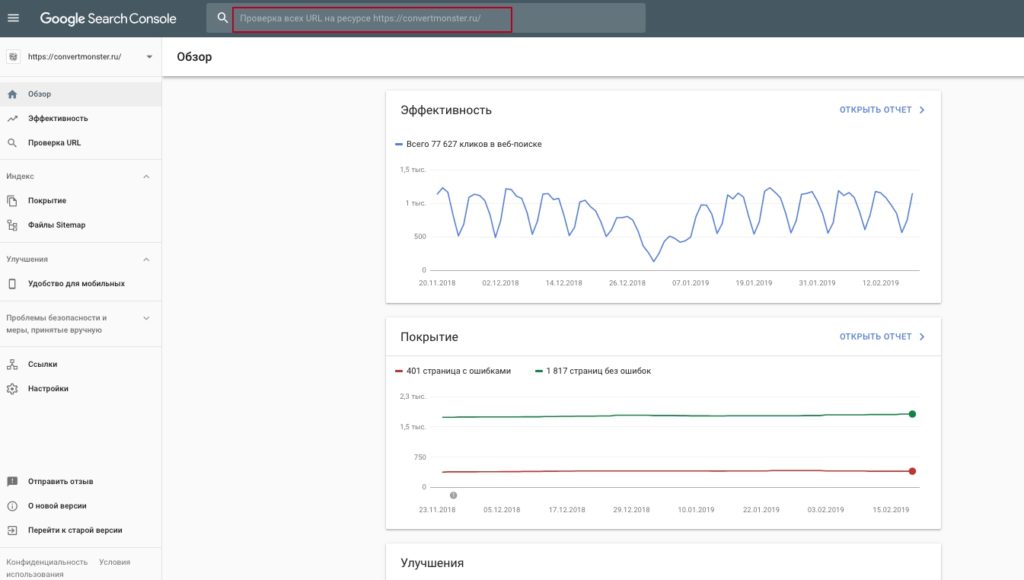

Внизу под строкой поиска (в Яндексе - в самой строке правее) отображается примерное количество страниц вашего сайта, проиндексированных поисковой системой. Второй способ - посмотреть в панели вебмастеров. В Google Search Console - вкладка “Индекс”, подраздел “Покрытие”. Здесь вы увидите график индексирования и сможете понимать саму тенденцию. Вверху также в табах есть количество страниц с ошибками, точное число проиндексированных страниц и количество страниц, заблокированных в файле robots.txt:

Второй способ - посмотреть в панели вебмастеров. В Google Search Console - вкладка “Индекс”, подраздел “Покрытие”. Здесь вы увидите график индексирования и сможете понимать саму тенденцию. Вверху также в табах есть количество страниц с ошибками, точное число проиндексированных страниц и количество страниц, заблокированных в файле robots.txt:

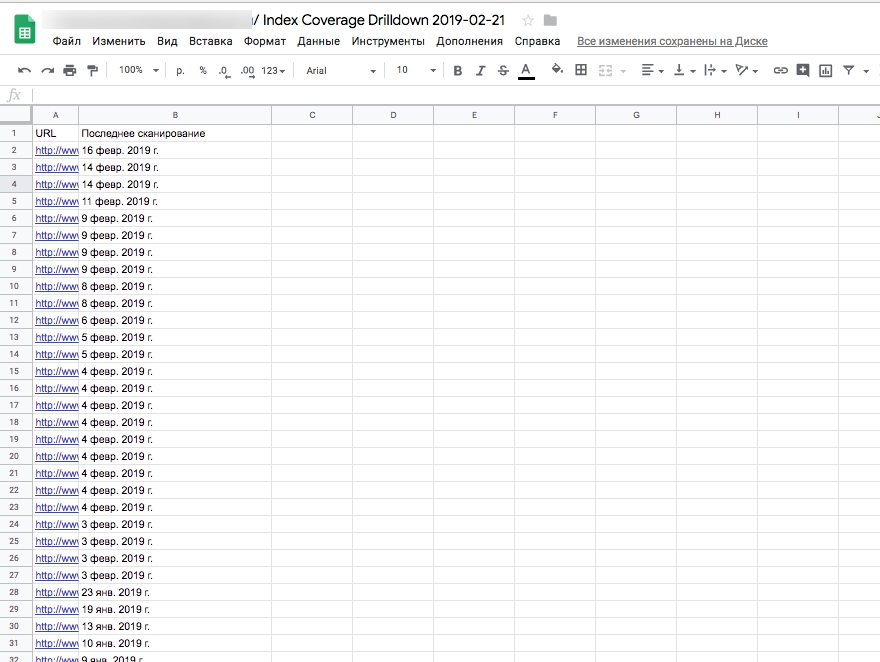

Ниже вы можете ознакомиться с каждой ошибкой, возникшей при сканировании ваших страниц роботом. Кроме того, вы можете выгрузить полный список всех страниц, которые не были проиндексированы по различными причинам. Также в списке будет указана дата последнего сканирования страницы поисковым роботом:

Ниже вы можете ознакомиться с каждой ошибкой, возникшей при сканировании ваших страниц роботом. Кроме того, вы можете выгрузить полный список всех страниц, которые не были проиндексированы по различными причинам. Также в списке будет указана дата последнего сканирования страницы поисковым роботом:

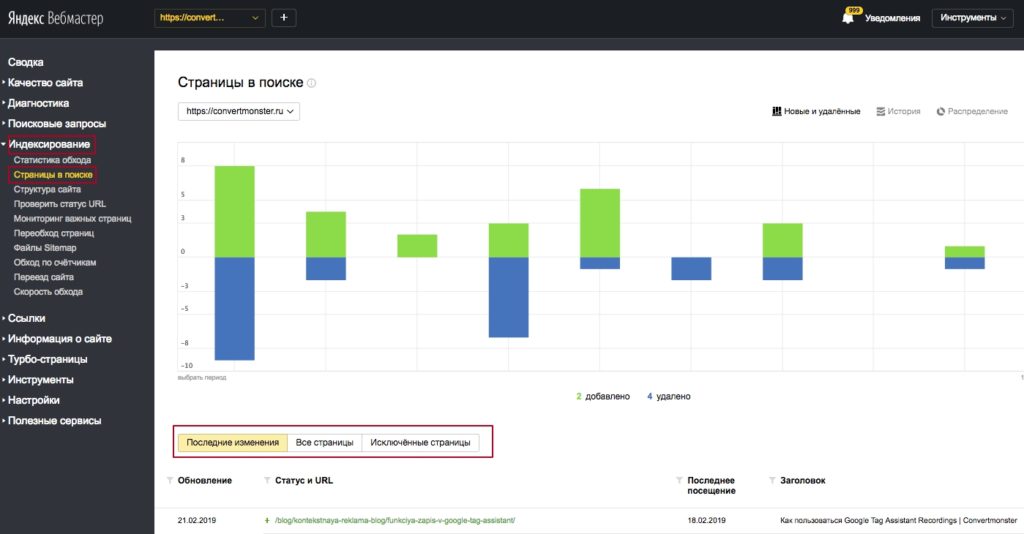

В Яндексе: заходим в Яндекс.Вебмастер, там выбираем раздел “Индексирование сайта”, подраздел “Страницы в поиске”. Здесь вы увидите, сколько страниц было добавлено в индекс и сколько было из индекса удалено за выбранный определенный период:

В Яндексе: заходим в Яндекс.Вебмастер, там выбираем раздел “Индексирование сайта”, подраздел “Страницы в поиске”. Здесь вы увидите, сколько страниц было добавлено в индекс и сколько было из индекса удалено за выбранный определенный период:

Идем дальше!

Идем дальше!

Вопрос 6. Как ускорить процесс индексации?

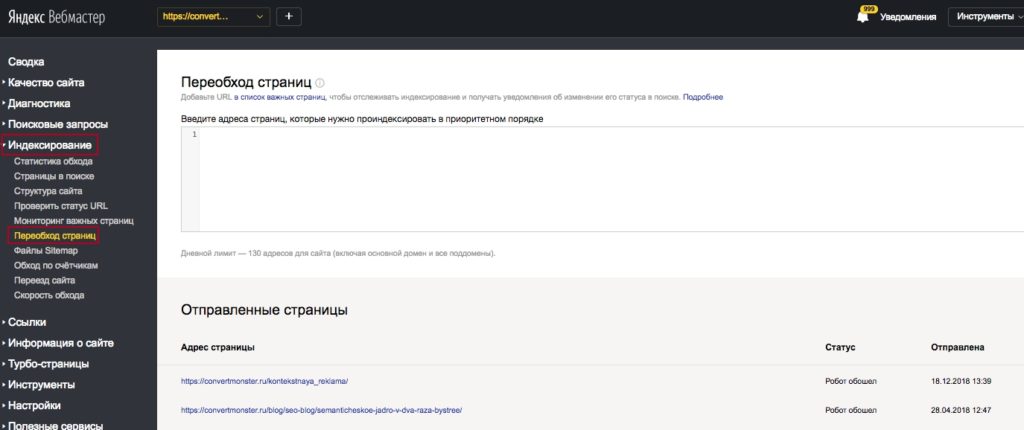

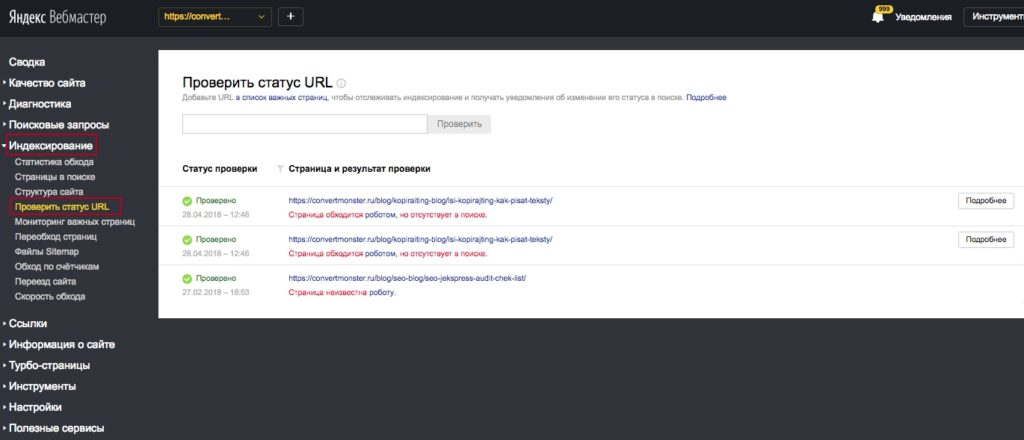

Это особенно актуально для медиа-порталов или для интернет-магазинов, где регулярно обновляются акции и новости. Такие страницы нужно отправить в индекс поисковика как можно быстрее. Как это сделать: В Яндекс.Вебмастере: во вкладке “Индексирование” переходим в подраздел “Переобход страниц”. Здесь введите URL тех страниц, которые вы бы хотели проиндексировать в первую очередь в приоритетном порядке (от самого важного до менее важного). Обратите внимание, что в этой полезной функции существует лимит - не более 20 страниц в день: Здесь же есть еще один полезный инструмент - “Проверить статус URL”. С его помощью можно проверить, проиндексирована ли конкретная страница:

Здесь же есть еще один полезный инструмент - “Проверить статус URL”. С его помощью можно проверить, проиндексирована ли конкретная страница:

В Google Search Console: в обновленном интерфейсе этот процесс делается немного иначе, чем в старых версиях. Вверху в шапке панели либо на боковой панели в разделе “Проверить URL” введите URL интересующей вас страницы и… проверьте его!

Дальше вы увидите результаты проверки, здесь вам просто нужно нажать на кнопку “Запросить индексирование”:

В Google Search Console: в обновленном интерфейсе этот процесс делается немного иначе, чем в старых версиях. Вверху в шапке панели либо на боковой панели в разделе “Проверить URL” введите URL интересующей вас страницы и… проверьте его!

Дальше вы увидите результаты проверки, здесь вам просто нужно нажать на кнопку “Запросить индексирование”:

Кроме того, не забывайте про ряд общих требований - их соблюдение обязательно оценит поисковый робот и будет заглядывать к вам на сайт чаще:

Кроме того, не забывайте про ряд общих требований - их соблюдение обязательно оценит поисковый робот и будет заглядывать к вам на сайт чаще:

- Правильно составленные файлы robots.txt и Sitemap - об этом мы писали в предыдущей части статьи, и снова напоминаем. Поисковые роботы обращают на них внимание в первую очередь.

- Как можно чаще обновляйте информацию на сайте. Роботы учитывают это и подбирают определенную тактику обхода под сайт.

- Общие требования по юзабилити и контенту. Удобно и интересно пользователю - нравится роботам.

- Постинг, активность в социальных сетях. Роботы могут также заходить на ваш сайт и по внешним ссылкам с крупных сайтов с хорошей репутацией и релевантной тематикой.

Вопрос 7. Какими должны быть ссылки и размер страниц?

- Количество входящих ссылок на ресурс, должно в разы превышать количество ссылок исходящих (seo in>seo out).

- Не увлекайтесь редиректами. А если ставите постоянное или временное перенаправление — ведите на целевую работоспособную страницу.

- Дублирующий контент на страницах усложняет процесс индексирования, такие страницы тратят краулинговый бюджет. Тег canonical помогает указать приоритетную страницу для выдачи

- Страницы с установленным тегом noindex не участвуют в выдаче, но сканируются роботом, т.е. на них расходуется бюджет, выделенный на весь сайт. Проверьте, оправданно ли наличие данного тега на странице, или ее можно спокойно закрыть в robots.

- Страницы с минимальным количеством контента чаще всего помечаются как некачественные и не участвуют в ранжировании, а страницы весом менее 1кб вообще не индексируются.

- Наличие ошибочных кодов ответа сервера (неработающие страницы, с кодом ответа 4xx, проблемы с сервером и ответ с кодом 5xx) для всех переобходов напрасно тратится бюджет. Только постоянный мониторинг сайта поможет избежать таких проблем.

- К URL также масса требований:

- без динамических параметров;

- ЧПУ;

- латиницей (кириллицу лучше не использовать, но допустимо);

- в идеале должен включать ключевой запрос, без пересапама, естественно;

- длиной 3-5 слов;

- не должен совпадать с H1;

- прописаны в нижнем регистре;

- в качестве разделителей использовать дефис, а не нижнее подчеркивание.

Вопрос 8. Краулинговый спрос и бюджет: что об этом нужно знать?

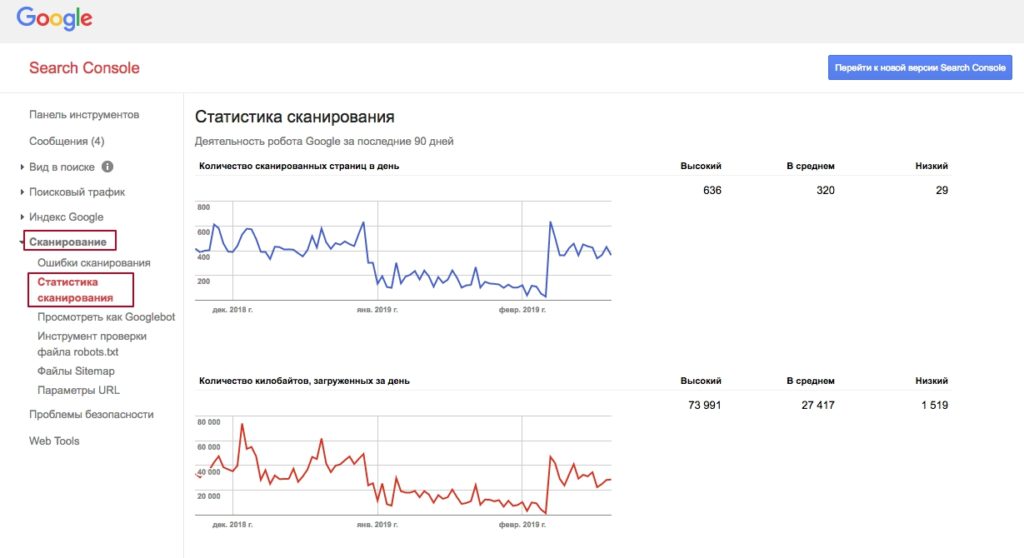

Этот вопрос касается исключительно поисковой системы Google и, судя по заявлениям представителя компании Гэри Илша, должен беспокоить только крупные сайты. Под краулинговым спросом понимается то количество страниц сайта, которые изначально хочет просканировать Google. Краулинговый бюджет - это число страниц, которое Googlebot и хочет, и может просканировать за определенный период. Смысл в том, что чем выше этот показатель у вашего сайта, тем быстрее робот Google сможет просканировать по-настоящему важные и ценные страницы вашего сайта. Проверить примерный краулинговый бюджет можно только в старой версии GSC. Для этого во вкладке “Сканирование” перейдите в раздел “Статистика сканирования”: Как контролировать эту цифру? Для начала очистить сайт от мусора. Снова вспоминаем про robots и sitemap: правильно составленные файлы индексации становятся первоочередным ориентиром для поискового робота, какие страницы не нужно обходить, а какие - нужно в первую очередь.

Кроме того, можно настроить параметр last-modified:

HTTP заголовок Last-Modified сообщает клиенту время последнего изменения страницы. Если клиент (браузер, поисковый робот) получил заголовок Last-Modified, то при следующем обращении к адресу, (при условии, что страница есть в локальном кеше), он добавит вопрос If-Modified-Since (не изменилась ли страница после даты, полученной в Last-Modified). В свою очередь сервер, получив запрос If-Modified-Since должен сверить полученную временную метку с временем последнего изменения страницы и, если страница не изменялась ответить 304 Not Modified.

Проще говоря: код ответа сервера 304 дает понять поисковому роботу, что страница не менялась, следовательно ее не нужно повторно сканировать. В таком случае количество страниц, которые боту нужно просканировать, может существенно снизиться, что позитивно повлияет на показатель скорости обхода.

***

Индексация - вещь очень объемная, вопросов явно больше, чем 8. Наверняка они найдутся и у вас. Пишите в комментариях - постараемся ответить как можно детальнее.

Или начните

Как контролировать эту цифру? Для начала очистить сайт от мусора. Снова вспоминаем про robots и sitemap: правильно составленные файлы индексации становятся первоочередным ориентиром для поискового робота, какие страницы не нужно обходить, а какие - нужно в первую очередь.

Кроме того, можно настроить параметр last-modified:

HTTP заголовок Last-Modified сообщает клиенту время последнего изменения страницы. Если клиент (браузер, поисковый робот) получил заголовок Last-Modified, то при следующем обращении к адресу, (при условии, что страница есть в локальном кеше), он добавит вопрос If-Modified-Since (не изменилась ли страница после даты, полученной в Last-Modified). В свою очередь сервер, получив запрос If-Modified-Since должен сверить полученную временную метку с временем последнего изменения страницы и, если страница не изменялась ответить 304 Not Modified.

Проще говоря: код ответа сервера 304 дает понять поисковому роботу, что страница не менялась, следовательно ее не нужно повторно сканировать. В таком случае количество страниц, которые боту нужно просканировать, может существенно снизиться, что позитивно повлияет на показатель скорости обхода.

***

Индексация - вещь очень объемная, вопросов явно больше, чем 8. Наверняка они найдутся и у вас. Пишите в комментариях - постараемся ответить как можно детальнее.

Или начните

с SEO-аудита вашего сайта

Получить предложение! Подпишись и следи за выходом новых статей в нашем монстрограмме Остались вопросы? Не нашли ответ на интересующий Вас вопрос? Или не нашли интересующую Вас статью? Задавайте вопросы и темы статей которые Вас интересуют в комментариях.

28.02.2019

28.02.2019  3 071

3 071

Комментарии

Спасибо, хорошо все описали